Das Buzzword des Jahres 2026 heißt »Agentic AI« oder auf Deutsch: KI-Agenten. Wer in der Tech-Welt unterwegs ist, hört den Begriff inzwischen täglich. Aber was steckt dahinter? Und warum sollte das jemanden interessieren, der keine Server administriert und keine Startups gründet?

Die kurze Antwort: KI-Agenten sind die nächste Stufe nach ChatGPT. Sie antworten nicht nur, sie handeln. Und das verändert einiges.

Lerne die Bildungssprache! Das praktische Handbuch schlauer Wörter unterstützt dich mit über 1.600 durchdachten Einträgen. Besser verstehen und klüger schreiben. Verständliche Erläuterungen und lebensnahe Beispiele erleichtern das Einprägen. Jetzt ansehen

Lerne die Bildungssprache! Das praktische Handbuch schlauer Wörter unterstützt dich mit über 1.600 durchdachten Einträgen. Besser verstehen und klüger schreiben. Verständliche Erläuterungen und lebensnahe Beispiele erleichtern das Einprägen. Jetzt ansehen

Inhaltsverzeichnis

Der Unterschied zu dem, was du kennst

ChatGPT, Claude und Gemini sind reaktiv. Du gibst einen Befehl, sie liefern eine Antwort. Dann wartest du. Dann gibst du den nächsten Befehl. Das funktioniert, ist aber mühsam. Du bist der Fahrer, die KI ist der Motor.

KI-Agenten funktionieren anders. Du gibst ein Ziel vor, und der Agent erledigt den Rest. Er plant, recherchiert, nutzt Werkzeuge, korrigiert Fehler, fragt nach, wenn nötig, und liefert am Ende ein Ergebnis. Du bist nicht mehr der Fahrer, sondern der Auftraggeber.

Das ist übrigens etwas anderes als klassische Automatisierung. Robotic Process Automation (RPA), also Software-Roboter, die Routineaufgaben erledigen, folgen starren Regeln: Wenn X passiert, tue Y. KI-Agenten dagegen erstellen selbst einen Plan, basierend auf dem Ziel, das du vorgibst. RPA führt ein Script aus; ein Agent schreibt das Script.

Für reine Recherche gibt es übrigens schon heute Lösungen, die in diese Richtung gehen: Deep Research bei ChatGPT, Claude und Gemini durchsucht eigenständig Quellen, bewertet sie und liefert strukturierte Berichte. Das ist agentenähnlich, aber noch begrenzt – am Ende steht ein Dokument, dann ist Schluss.

Ein vollwertiger Agent geht weiter. Ein Beispiel: Du organisierst ein kleines Fachsymposium zu antiker Rhetorik. Bei einem klassischen Chatbot fragst du: »Wer forscht aktuell zu dem Thema?« Er nennt Namen. Du fragst nach Kontaktdaten. Er findet manche. Du fragst, wie man eine Einladung formuliert. Er schreibt einen Entwurf. Jeder Schritt ein neuer Prompt.

Ein KI-Agent bekommt stattdessen den Auftrag: »Finde 10 passende Referenten zum Thema antike Rhetorik und ihre Rezeption, recherchiere deren Kontaktdaten, schreibe personalisierte Einladungsmails, schicke sie mir zur Freigabe, tracke die Antworten und erstelle eine Übersicht, wer zugesagt hat.« Er recherchiert, schreibt, wartet auf dein Okay, verschickt, liest die Antworten, sortiert sie und hält dich auf dem Laufenden. Du steuerst, aber du musst nicht jeden Handgriff selbst machen.

Warum jetzt?

Die Technik dafür existiert nicht erst seit gestern. Schon in den 1990er Jahren forschte man an Multi-Agenten-Systemen. Was sich geändert hat: Die Sprachmodelle sind inzwischen gut genug, um komplexe Aufgaben zu verstehen, zu planen und auszuführen.

Vier Entwicklungen treiben das Thema 2026 voran: Erstens sind die Modelle schlauer geworden. Sie können mehrstufige Probleme lösen, nicht nur einzelne Fragen beantworten. Zweitens gibt es inzwischen Standards, wie Agenten miteinander kommunizieren und Werkzeuge nutzen können. Drittens sind kleinere, spezialisierte Modelle erschienen, die effizienter arbeiten als die großen Generalisten. Und viertens: Die ersten produktionsreifen Systeme funktionieren tatsächlich.

Was Agenten heute schon können

Die Beispiele sind weniger futuristisch, als man denkt: Im Kundenservice beantworten Agenten Anfragen nicht nur, sie lösen Probleme. Sie prüfen Bestellstatus, veranlassen Rückerstattungen, ändern Lieferadressen, alles ohne menschliches Zutun.

Im Marketing analysieren Agenten die Performance von Kampagnen, schlagen Verbesserungen vor und setzen sie um. Sie posten nicht nur Content, sie optimieren ihn kontinuierlich.

In der Softwareentwicklung schreiben Agenten Code, testen ihn, dokumentieren ihn und beheben Fehler. Claude Code ist ein frühes Beispiel dafür, wie so etwas aussehen kann.

Für Einzelpersonen gibt es Agenten, die E-Mails zusammenfassen, Termine koordinieren, Recherchen durchführen und To-do-Listen abarbeiten. Ein digitaler Assistent, der tatsächlich assistiert.

Die Sache mit der Autonomie

Hier wird es interessant und heikel zugleich. Ein Agent, der selbstständig handelt, kann auch selbstständig Fehler machen. Oder Dinge tun, die du nicht wolltest.

Die Branche spricht von »Guard Rails«, also Leitplanken, die das Handeln begrenzen. Ein Agent darf Termine verschieben, aber keine Verträge unterschreiben. Er darf E-Mails verfassen, aber nicht ohne Freigabe verschicken. Er darf recherchieren, aber keine Passwörter speichern.

Das ist im Grunde nichts Neues. Auch ein menschlicher Mitarbeiter darf nicht alles. Ein Sachbearbeiter hat andere Befugnisse als ein Abteilungsleiter, und selbst ein Geschäftsführer hat eine Geschäftsordnung, die regelt, ab welcher Summe er den Aufsichtsrat fragen muss. Agenten brauchen dasselbe: eine klare Stellenbeschreibung, definierte Zeichnungsberechtigungen und – im Zweifel – jemanden, der haftet, wenn etwas schiefgeht.

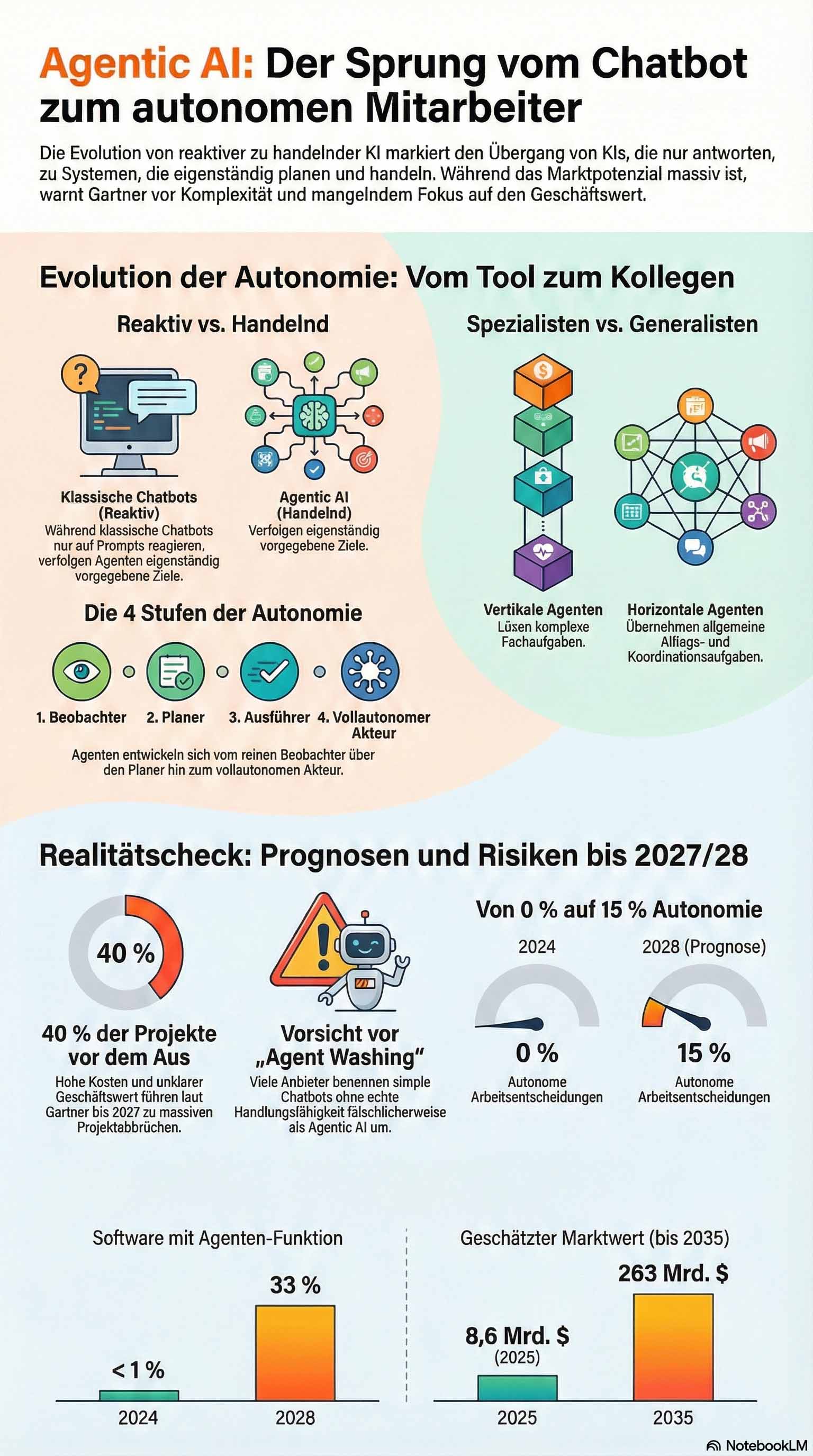

Vier Stufen der Autonomie

Nicht jeder Agent arbeitet gleich selbstständig. In der Praxis lassen sich vier Stufen unterscheiden, ähnlich wie bei autonomen Fahrzeugen:

Stufe 1 – Beobachten und Vorschlagen: Der Agent analysiert Daten und meldet Auffälligkeiten, handelt aber nicht. Beispiel: Er bemerkt einen Terminkonflikt in deinem Kalender und zeigt eine Warnung an. Du entscheidest, was passiert.

Stufe 2 – Planen und Vorlegen: Der Agent erkennt das Problem, entwickelt einen Lösungsplan und präsentiert ihn dir. Beispiel: Er schlägt vor, das Meeting auf Donnerstag zu verschieben, und erklärt, warum das funktioniert. Du genehmigst den Plan.

Stufe 3 – Vorbereiten und Bestätigen lassen: Der Agent erledigt die Vorarbeit komplett und wartet auf dein Okay für den letzten Schritt. Beispiel: Er hat die E-Mails an alle Teilnehmer bereits formuliert, die neuen Kalendereinträge erstellt – du klickst nur noch auf »Absenden«.

Stufe 4 – Autonom handeln: Der Agent entscheidet und handelt innerhalb festgelegter Grenzen selbstständig. Du siehst hinterher nur eine Benachrichtigung: »Terminkonflikt gelöst, Meeting auf Donnerstag verschoben.«

Die meisten Menschen werden verschiedene Stufen für verschiedene Aufgaben wählen. Für Terminverschiebungen vielleicht Stufe 4, für Finanztransaktionen eher Stufe 2. Das Entscheidende ist, dass du diese Wahl hast – und dass das System sie respektiert.

Die Kehrseite

Die Risiken sind real. Ein Agent, der handeln kann, kann eben alles handeln. Botfarmen, die Kryptowährungen traden, gibt es längst. Pokerbots, die an mehreren Tischen gleichzeitig spielen, ebenfalls. Das war noch mit relativ dummer Automatisierung. Mit echten KI-Agenten wird das raffinierter: Sie könnten Marktbewegungen interpretieren, auf Nachrichten reagieren, Strategien anpassen – alles ohne menschliches Zutun.

Und es geht nicht nur um Finanzmärkte. Ein Agent könnte deine Steuererklärung über Elster einreichen. Praktisch? Ja. Aber wer prüft, ob die Angaben stimmen? Ein anderer Agent könnte über Nacht Beschwerdebriefe an sämtliche Nachbarn verschicken – höflich formuliert, juristisch wasserdicht, aber gesellschaftlich desaströs. Und auf Dating-Plattformen wie Tinder? Wer garantiert dir, dass die charmante Person, mit der du seit Wochen schreibst, nicht ein Agent ist, der für jemand anderen flötet?

Das sind keine dystopischen Fantasien. Die technischen Möglichkeiten existieren bereits. Was noch fehlt, sind klare Regeln – gesellschaftlich, rechtlich, technisch. Wer haftet, wenn ein Agent Geld verzockt? Wer kontrolliert, ob er sich an Regeln hält? Und wie erkennst du überhaupt, ob du mit einem Menschen oder einem Agenten interagierst?

Wie viel Autonomie du einem Agenten gibst, ist also eine Entscheidung mit Konsequenzen. Manche lässt man an der langen Leine, andere kontrolliert man bei jedem Schritt. Die Kunst liegt im richtigen Maß – und in klaren Regeln, bevor der Agent loslegt.

Was du heute schon ausprobieren kannst

Du brauchst keine teure Software und kein Entwicklerteam. ChatGPT und Claude haben bereits agentenähnliche Funktionen.

Ein einfacher Einstieg: Gib der KI nicht nur eine Frage, sondern eine Rolle und ein Ziel.

Du bist mein persönlicher Recherche-Assistent für meine Doktorarbeit über spätantike Philosophie. Deine Aufgabe: Finde die 5 wichtigsten Sekundärquellen zum Einfluss von Plotin auf Augustinus. Fasse jede Quelle in 3 Sätzen zusammen. Nenne Autoren, Erscheinungsjahr und erkläre, warum die Quelle relevant ist. Wenn du unsicher bist, sag es.Das ist noch kein vollwertiger Agent, aber ein Schritt in diese Richtung. Du gibst ein Ziel vor, nicht jeden einzelnen Schritt.

Fortgeschrittener wird es mit Claude Projects oder Custom GPTs, wo du dauerhafte Anweisungen hinterlegen kannst. Der Agent »weiß« dann bei jeder Unterhaltung, wer du bist, was du willst und wie er arbeiten soll.

Die zwei Arten von Agenten

Man unterscheidet grob zwischen vertikalen und horizontalen Agenten.

Vertikale Agenten sind Spezialisten. Sie können eine Sache besonders gut: juristische Texte analysieren, Marketingkampagnen optimieren, Code debuggen. Sie kennen ihre Domäne in- und auswendig.

Horizontale Agenten sind Generalisten. Sie können vieles, aber nichts perfekt. Sie eignen sich für alltägliche Aufgaben, die keine Tiefe erfordern: E-Mails sortieren, Termine planen, einfache Recherchen.

Die meisten praktischen Lösungen kombinieren beides. Ein »Manager-Agent« koordiniert mehrere Spezialisten. Einer recherchiert, einer schreibt, einer prüft. Zusammen erledigen sie komplexe Aufgaben.

Was das für die Zukunft bedeutet

Die Prognosen sind eindeutig: Laut Gartner werden bis Ende 2026 etwa 40 Prozent aller Unternehmensanwendungen eingebettete KI-Agenten enthalten – ein gewaltiger Sprung von unter 5 Prozent im Vorjahr. Der Markt für autonome KI-Agenten soll laut Research Nester von 8,6 Milliarden Dollar (2025) auf 263 Milliarden bis 2035 wachsen – jährlich um etwa 40 Prozent.

Für dich persönlich bedeutet das: Die Art, wie du mit Software interagierst, wird sich ändern. Weniger Klicken, mehr Beauftragen. Weniger Formulare ausfüllen, mehr Ziele formulieren.

Das klingt nach Erleichterung, und das ist es auch. Aber es erfordert eine neue Kompetenz: klar sagen können, was man will. Wer sein Ziel nicht definieren kann, dem nützt auch der beste Agent nichts.

Ein realistischer Blick

KI-Agenten sind keine Magie. Sie machen Fehler, manchmal grobe. Sie verstehen Kontext nicht immer richtig. Sie brauchen klare Anweisungen und Grenzen.

Viele Pilotprojekte bleiben in der Demo-Phase stecken, weil die Systeme in der echten Welt auf Probleme stoßen, die im Labor nicht vorkamen. Heterogene Daten, lückenhafte Dokumentation, Sicherheitsanforderungen, all das bremst. Gartner schätzt, dass über 40 Prozent der KI-Agenten-Projekte bis Ende 2027 scheitern könnten – weil die Kosten explodieren oder der Geschäftswert unklar bleibt.

Trotzdem: Die Richtung ist klar. Die KI entwickelt sich vom Werkzeug zum Mitarbeiter. Nicht heute, nicht vollständig, aber Schritt für Schritt.

Wer sich früh damit beschäftigt, hat einen Vorsprung. Nicht, weil man programmieren lernen muss, sondern weil man lernen muss, Aufgaben zu delegieren, die man bisher selbst erledigt hat. Das ist weniger technisch, als es klingt. Aber es verändert die Art, wie wir arbeiten.