Die Angst ist groß: Ein Algorithmus entscheidet, ob dein Text als KI-generiert gilt – mit allen Konsequenzen. Doch wie zuverlässig sind diese Detektoren überhaupt? Die kurze Antwort lautet, weniger, als du denkst. Besonders bei deutschen Texten.

Inhaltsverzeichnis

Schauen wir uns an, wie KI-Detektoren funktionieren, wo ihre Grenzen liegen und was tatsächlich hilft, wenn du bessere Texte schreiben willst – ob mit oder ohne KI-Unterstützung.

Wie KI-Detektoren funktionieren

KI-Detektoren analysieren Texte nach bestimmten Mustern. Sie messen zwei Hauptfaktoren:

Perplexität: Wie vorhersagbar ist das nächste Wort? KI-Texte tendieren zu gleichmäßigen, erwartbaren Formulierungen. Menschliche Texte sind überraschender, sprunghafter, manchmal unlogisch. Jedenfalls meistens.

Burstiness: Wie variiert die Satzlänge? Menschen schreiben mal kurz, mal lang. KI produziert oft gleichmäßigere Strukturen.

Ein gut geschriebener menschlicher Text kann fälschlich als KI-generiert erkannt werden. Umgekehrt funktioniert die Täuschung nicht: KI-Texte lassen sich nicht zuverlässig als menschlich tarnen – jedenfalls kaum, ohne sie unbrauchbar zu machen. Ich habe das schon öfter ausprobiert. Gegen die statistischen Marker, die unter der Oberfläche liegen, kommt man nicht an. Es bringt nichts, der KI zu sagen, dass sie das lassen soll. Sie kann das nicht.

Die Grenzen der Erkennung

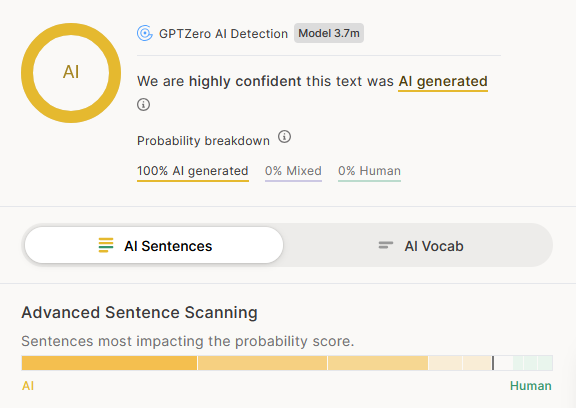

Die Zahlen sind ernüchternd. Laut aktuellen Studien erreichen die besten Scanner eine Genauigkeit von etwa 70–80 Prozent. Das bedeutet: Jeder dritte bis vierte Text wird falsch eingestuft.

Bei deutschen Texten sieht es noch schlechter aus. Die meisten Detektoren wurden auf englischen Daten trainiert. Analysen zeigten: Originality.ai erkannte bei englischen Texten 94 Prozent korrekt – bei deutschen nur 34 Prozent. GPTZero lag bei deutschen Texten bei etwa 65 Prozent.

Besonders absurd: GPTZero stufte Kapitel aus »Harry Potter« als »wahrscheinlich KI-generiert« ein – ein Roman von 1997, also fast 30 Jahre vor ChatGPT. Auch die Bibel wurde schon als KI-Text klassifiziert. Was sagt das über die höchste Instanz aus …

Eine Studie unter Leitung von Prof. Dr. Debora Weber-Wulff (HTW Berlin) zeigte: Bei überarbeiteten KI-Texten sinkt die Erkennungsgenauigkeit auf 50 Prozent. Das entspricht dem Zufallsniveau – man könnte genauso gut eine Münze werfen. Aber sind bearbeitete KI-Texte überhaupt noch KI Texte? Und wie ist es umgekehrt, wenn die KI deinen selbstgeschreibenen Text verbessert?

Der menschliche Faktor

Erfahrene Lehrer, Lektoren und Redakteure erkennen KI-Texte oft besser als jeder Algorithmus. Nicht durch Messen von Perplexität, sondern durch Instinkt – geschult an tausend Texten.

Was sie bemerken: Der Text klingt »irgendwie« nicht nach dem Schüler. Die Wortwahl passt nicht zum bisherigen Niveau. Argumente werden aufgereiht, aber nicht durchdacht. Die persönliche Note fehlt – keine Meinung, kein Stolpern, keine Überraschung.

Wer jemanden kennt, wer dessen frühere Arbeiten gelesen hat, dessen Denkweise versteht, merkt schnell, wenn plötzlich jemand anderes zu sprechen scheint. Das ist keine Magie, sondern Instinkt. Und diese Erfahrung lässt sich nicht durch einen Prozentwert ersetzen.

Das heißt auch: Wenn dein Lehrer deinen Schreibstil kennt, schützt dich kein Humanizer der Welt. Der beste Schutz ist, selbst zu schreiben – oder KI so einzusetzen, dass deine eigene Stimme erkennbar bleibt.

Warum das Probleme verursacht

KI-Detektoren liefern keine Beweise, sondern Wahrscheinlichkeiten. Ein Score von 70 Prozent bedeutet: Der Algorithmus vermutet, dass der Text mit 70-prozentiger Wahrscheinlichkeit KI-generiert ist. Das ist keine Grundlage für Sanktionen.

Trotzdem werden diese Tools in Schulen und Universitäten eingesetzt. Studierende geraten unter Verdacht, obwohl sie selbst geschrieben haben. Ironischerweise trifft es oft die Falschen: Wer sehr strukturiert und fehlerfrei schreibt, wird eher als »KI« eingestuft. Wer schlampig arbeitet, fliegt unter dem Radar.

Nicht-Muttersprachler sind besonders benachteiligt. Eine Stanford-Studie zeigte: Über 60 Prozent ihrer Texte werden fälschlicherweise als KI-generiert markiert.

Die aktuellen Tools

Hier eine realistische Einschätzung der gängigen Detektoren:

GPTZero: Kostenloser Einstieg, analysiert Perplexität und Burstiness. Funktioniert auf Englisch besser als auf Deutsch. Erklärt immerhin, warum ein Text als KI eingestuft wird.

Originality.ai: Kombiniert KI- und Plagiatsprüfung. Auf Englisch brauchbar, auf Deutsch unzuverlässig. Kostenpflichtig nach Credits.

Copyleaks: Unterstützt über 30 Sprachen, wird in Schulen eingesetzt. Technische Oberfläche, aber solide Ergebnisse.

Detectora: Speziell für deutsche Texte entwickelt, auf über einer Million deutscher Texte trainiert. Behauptet, robuster gegen Täuschungsversuche zu sein.

Turnitin: Standard an vielen Hochschulen, ursprünglich für Plagiatserkennung. Hat jetzt einen KI-Erkennungsmodus, der nur für Lehrende zugänglich ist. Bei Werten zwischen 1 und 19 Prozent zeigt Turnitin seit Juli 2024 nur noch »*%« an – ein Eingeständnis der Ungenauigkeit.

Kein Tool ist zuverlässig genug, um als alleinige Grundlage für Bewertungen zu dienen. Die Technische Hochschule Augsburg und andere Institutionen raten explizit davon ab, KI-Detektoren für Prüfungsentscheidungen zu verwenden.

Was KI-Texte verrät

Jenseits von Algorithmen gibt es Merkmale, die KI-Texte für Menschen erkennbar machen:

Das Template: ChatGPT liebt eine bestimmte Struktur – Einleitung, Liste mit Punkten, Zusammenfassung, Warnung. Immer das gleiche Schema.

Phrasen aus der Frühzeit: In den Anfängen von ChatGPT (Version 3.5) gab es Running Gags wie »Tauche ein« oder »Ein Kaleidoskop« – Formulierungen, die so häufig auftauchten, dass sie zum Erkennungszeichen wurden. Neuere Modelle haben das weitgehend abgelegt, aber ältere Texte verraten sich damit sofort. Im Englischen ist »delve into« bis heute ein bekannter Marker.

Glatte Perfektion: Keine Tippfehler, keine Stilbrüche, keine persönlichen Einschübe. Das wirkt steril.

Redundanz: KI wiederholt sich, produziert mehr Text als nötig, sagt dasselbe mit anderen Worten.

Englische Spuren: ChatGPT »denkt« auf Englisch und übersetzt. Manchmal schleichen sich englische Schreibweisen ein – »c« statt »k«, falsche Kommaplatzierung nach englischem Muster.

Inhaltliche Fehler: KI erfindet Fakten, verwechselt Zusammenhänge, halluziniert Quellen. Das fällt auf – aber erst, wenn jemand das prüft.

Prompt: Stil anpassen

Wenn du KI nutzt, gib ihr etwas von dir:

Hier ist ein Text, den ich selbst geschrieben habe: [Text einfügen]

Analysiere meinen Schreibstil:

- Satzlänge und -struktur

- Typische Wörter und Wendungen

- Ton (formal, locker, direkt?)

- Besonderheiten

Schreibe dann einen Text über [Thema] in exakt diesem Stil.Few-shot-Prompting nennt sich diese Technik: Du gibst der KI Beispiele, an denen sie sich orientiert. Je mehr Muster sie hat, desto besser trifft sie deinen Ton.

Prompt: Redundanzen eliminieren

Hier ist mein Text: [Text einfügen]

Prüfe auf:

1. Wiederholungen (gleiche Aussage mit anderen Worten)

2. Füllsätze, die nichts Neues beitragen

3. Überflüssige Einleitungen und Zusammenfassungen

4. Phrasen, die nach KI klingen

Markiere alles, was raus kann. Dann: Kürze den Text um 20%, ohne Inhalt zu verlieren.Prompt: Struktur aufbrechen

Dieser Text folgt einem typischen KI-Schema: [Text einfügen]

Ändere die Struktur:

- Keine Liste, stattdessen Fließtext

- Die Zusammenfassung kommt nicht ans Ende

- Fang nicht mit einer Definition an

- Baue einen persönlichen Einschub ein

- Variiere die Satzlängen stärker

Der Inhalt bleibt gleich, nur die Form ändert sich.Prompt: Selbst-Check

Analysiere diesen Text: [Text einfügen]

Bewerte aus der Perspektive eines KI-Detektors:

- Welche Stellen würden als »KI-typisch« eingestuft?

- Wo ist die Satzstruktur zu gleichmäßig?

- Welche Phrasen sind verdächtig?

- Was fehlt, um menschlicher zu wirken?

Gib mir konkrete Stellen zum Überarbeiten.Prompt: Persönlichkeit einbauen

Hier ist ein sachlicher Text: [Text einfügen]

Mache ihn persönlicher:

- Füge 2-3 Stellen ein, an denen der Autor eine Meinung äußert

- Baue eine kurze Anekdote oder ein konkretes Beispiel ein

- Ersetze generische Formulierungen durch spezifische

- Lass eine umgangssprachliche Wendung einfließen

Der Text soll nach einer echten Person klingen, nicht nach einem Lexikon.Was du selbst tun kannst

Unabhängig von Prompts – ein paar Handgriffe, die jeden Text menschlicher machen:

Variiere bewusst: Ein kurzer Satz. Dann ein längerer, der sich windet und mehrere Gedanken verbindet. Dann wieder Kürze. Das erzeugt Rhythmus.

Meinungen einbauen: »Ich halte das für übertrieben« oder »Das funktioniert erstaunlich gut« – solche Einschübe brechen die Neutralität.

Konkretes statt Allgemeines: Nicht »viele Menschen«, sondern »mein Kollege letzte Woche«. Nicht »in verschiedenen Bereichen«, sondern »im Marketing und in der Buchhaltung«.

Unvollkommenheit zulassen: Ein Gedankenstrich, der den Satz unterbricht. Ein Einschub in Klammern (auch wenn er streng genommen überflüssig ist). Das sind menschliche Fingerabdrücke.

Eigene Worte: Ersetze Begriffe, die nicht zu deinem aktiven Wortschatz gehören. Wenn du »prädestiniert« nie sagen würdest, schreib »geeignet«.

Humanizer – Finger weg

Es gibt Tools, die versprechen, KI-Texte »menschlicher« zu machen. Sie ersetzen Wörter durch Synonyme, bauen Fehler ein, strukturieren um. Das Ergebnis ist meist schlechter als der Ausgangstext.

Das Problem: Diese Tools optimieren auf Detektoren, nicht auf Leser. Ein Text, der GPTZero täuscht, kann trotzdem steril und leblos klingen. Und Detektoren werden besser – was heute funktioniert, fliegt morgen auf.

Besser: Selbst Hand anlegen. Das dauert länger, aber du verstehst, was du schreibst, und lernst dabei.

Was bleibt

KI-Detektoren sind Werkzeuge mit Grenzen. Sie können Hinweise geben, aber keine Beweise liefern. Wer sich auf sie verlässt – als Prüfer oder als Geprüfter – trifft Entscheidungen auf wackeliger Grundlage.

Die bessere Strategie: Texte schreiben, die gut sind. Die eine eigene Stimme haben. Die nicht nach Template klingen. Das schützt nicht nur vor Detektoren – es macht die Texte lesbarer, interessanter, überzeugender.

KI ist ein Werkzeug. Wie du es nutzt, entscheidet darüber, was am Ende herauskommt. Ein Hammer macht noch keinen Tischler – und ChatGPT macht noch keinen guten Autor.