Wie funktioniert ChatGPT? Die schnelle Antwort: Es sagt das nächste Wort vorher. Immer wieder, Wort für Wort, bis ein Text entsteht. Es gibt keine Recherche, kein Nachdenken, kein echtes Verständnis. Nur Statistik, trainiert an enormen Textmengen.

Erstmal klingt das wenig beeindruckend, aber trotzdem ist es die Grundlage für ein Werkzeug, das Millionen Menschen täglich nutzen. Und das ständig besser wird.

Wer versteht, wie dieses Prinzip funktioniert, versteht auch, warum ChatGPT manchmal brillant antwortet und manchmal völligen Unsinn erzählt. Beides hat denselben Grund.

Inhaltsverzeichnis

Was ChatGPT ist – und was nicht

ChatGPT ist ein Sprachmodell, entwickelt von OpenAI. Ein Sprachmodell hat kein Bewusstsein, kein Verständnis von Bedeutung und keine Absicht. Es weiß nichts über die Welt im menschlichen Sinn. Es arbeitet ausschließlich mit Sprache.

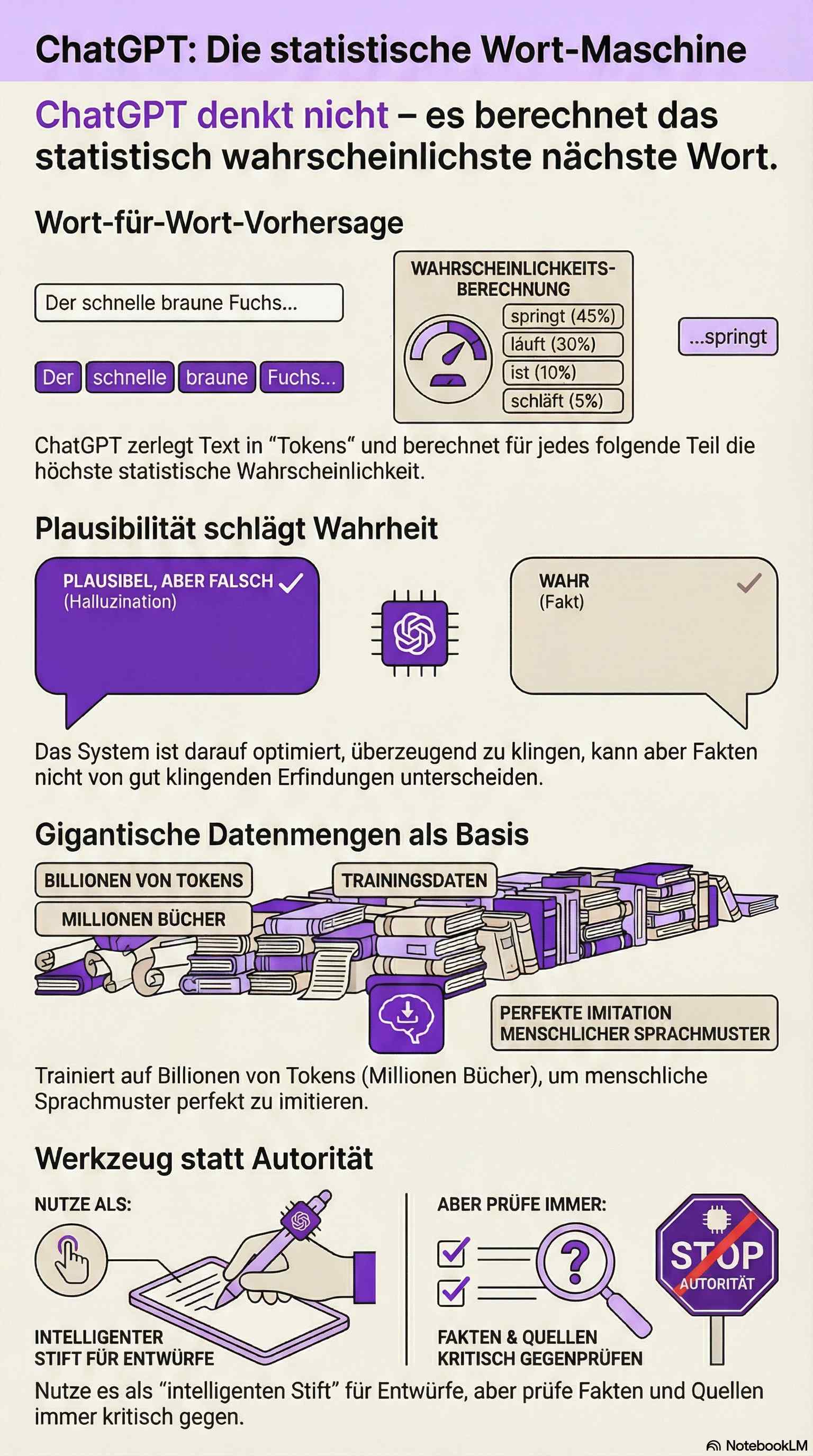

Das Modell wurde darauf trainiert, riesige Mengen Text zu analysieren und daraus Muster abzuleiten. Diese Muster beschreiben, welche Wörter typischerweise auf andere Wörter folgen. Wenn du ChatGPT eine Frage stellst, sucht es nicht nach einer Antwort. Es setzt deinen Text fort – so, wie es statistisch am plausibelsten ist.

Deshalb klingen Antworten oft klug oder durchdacht. Nicht, weil das System denkt, sondern weil es gelernt hat, wie denkender Text aussieht. Ein feiner, aber entscheidender Unterschied.

Stell dir eine extrem leistungsfähige Autovervollständigung vor. Die auf deinem Handy schlägt das nächste Wort vor. ChatGPT tut dasselbe – nur mit dem gesamten Wissen, das in Milliarden von Textseiten steckt, und mit einer Treffsicherheit, die verblüfft. Aber es bleibt dasselbe Prinzip. Kein Orakel. Kein denkendes Wesen. Eine statistische Maschine, die sehr, sehr gut darin ist, plausible Texte zu erzeugen.

Wie funktioniert das Training von ChatGPT?

Das Training läuft in mehreren Phasen. In der ersten wird das Modell mit gewaltigen Textmengen konfrontiert: Bücher, Artikel, Webseiten, Dialoge. Es lernt dabei keine Fakten, sondern Sprachmuster. Wie eine Erklärung aufgebaut ist. Wie Fragen formuliert werden. Wie Argumentationen klingen. Wie ein Witz funktioniert und wann ein Absatz endet.

Die Menge ist schwer vorstellbar. GPT-4 wurde auf schätzungsweise 13 Billionen Tokens trainiert – das entspricht grob dem Textinhalt von mehreren Millionen Büchern. Alles, was das Internet an frei zugänglichem Text hergibt, plus lizenzierte Datensätze (Stand 02/2025).

In einer späteren Phase kommt menschliches Feedback ins Spiel. Menschen bewerten Antworten, korrigieren Fehler, bevorzugen hilfreiche Formulierungen. Dieses Verfahren heißt RLHF – Reinforcement Learning from Human Feedback. Es macht ChatGPT nützlicher, höflicher und besser steuerbar.

Aber es hat eine Nebenwirkung: Das Modell lernt auch, dass Menschen Antworten bevorzugen, die ihnen gefallen – selbst wenn sie falsch sind. Eine überzeugende falsche Antwort schneidet im Training besser ab als eine trockene Korrektur. So entstehen Schmeichler statt Berater. Ein strukturelles Problem, an dem alle großen Anbieter arbeiten.

Tokens – die kleinsten Bausteine

ChatGPT arbeitet nicht mit ganzen Wörtern oder Sätzen, sondern mit sogenannten Tokens. Ein Token kann ein Wort sein, ein Wortteil oder auch nur ein Zeichen. »Unwahrscheinlich« wird zum Beispiel in drei Tokens zerlegt: »Un«, »wahr«, »scheinlich«.

Für jedes mögliche nächste Token berechnet das Modell eine Wahrscheinlichkeit. Das Token mit der höchsten Wahrscheinlichkeit wird ausgewählt, an den Text angehängt, und der Prozess beginnt von vorn. So entsteht Wort für Wort eine Antwort.

Wichtig dabei: ChatGPT plant keine Antwort im Voraus. Es weiß beim ersten Wort noch nicht, wie der letzte Satz aussehen wird. Das erklärt, warum es manchmal mitten im Absatz die Richtung wechselt oder sich in Widersprüche verstrickt. Es gibt keinen Masterplan, nur den nächsten Schritt.

Kontext statt Gedächtnis

ChatGPT hat kein dauerhaftes Gedächtnis. Es merkt sich nichts über einzelne Gespräche hinweg – jedenfalls nicht von allein. Innerhalb eines Gesprächs sieht es nur den aktuellen Kontext: einen begrenzten Ausschnitt des bisherigen Textes.

Dieses Kontextfenster hat eine feste Größe, gemessen in Tokens. Bei GPT-4o sind es 128.000 Tokens, bei GPT-5.2 bis zu 512.000 (Stand 02/2025). Klingt viel, reicht aber bei langen Gesprächen oder umfangreichen Dokumenten nicht immer.

Alles, was außerhalb dieses Fensters liegt, ist für das Modell unsichtbar. Das erklärt, warum ChatGPT Details »vergisst«, warum lange Unterhaltungen unübersichtlich werden und warum präzise Eingaben bessere Ergebnisse liefern als vage Fragen. Wer weiß, wie das Kontextfenster funktioniert, stellt bessere Prompts.

OpenAI hat mittlerweile eine Gedächtnisfunktion eingebaut, die sich bestimmte Informationen über Gespräche hinweg merkt. Aber das ist eine Zusatzschicht auf dem eigentlichen Modell, kein echtes Erinnern. Eher ein Spickzettel, den jemand anderes für das Modell schreibt.

Wie eine Antwort entsteht

Vereinfacht läuft jede Antwort so ab: Du gibst Text ein. Der Text wird in Tokens zerlegt. Das Modell berechnet Wahrscheinlichkeiten für das nächste Token. Ein Token wird ausgewählt. Der Vorgang wiederholt sich, bis die Antwort fertig ist.

Es gibt dabei keine Prüfung auf Wahrheit, keine Recherche im Hintergrund und kein inneres Verständnis. Alles basiert auf Wahrscheinlichkeit und Mustererkennung. Das ist gleichzeitig die größte Stärke und die größte Schwäche.

Neuere Modelle wie GPT-o3 oder Claude 3.5 Sonnet können vor der eigentlichen Antwort eine interne Gedankenkette durchlaufen – sogenanntes Chain-of-Thought-Reasoning. Das verbessert die Ergebnisse bei logischen und mathematischen Aufgaben erheblich. Aber auch diese Gedankenkette ist letztlich generierter Text, keine echte Reflexion.

Warum ChatGPT überzeugend klingt – auch wenn es falsch liegt

ChatGPT ist darauf optimiert, sprachlich passende und flüssige Antworten zu erzeugen. Nicht darauf, Fehler zu erkennen oder Unsicherheit zu zeigen. Wenn eine falsche Information sprachlich gut in den Kontext passt, wird sie mit derselben Selbstsicherheit ausgegeben wie eine richtige.

Das nennt man Halluzination. Technisch ist das kein Aussetzer, sondern eine logische Folge der Funktionsweise. Das Modell bevorzugt Plausibilität, nicht Wahrheit. Es erfindet Studien, die nicht existieren, zitiert Autoren, die nie geschrieben haben, und behauptet Dinge mit einer Bestimmtheit, die jeden Faktencheck erröten lässt.

Das ist keine Böswilligkeit. Das System kann schlicht nicht unterscheiden zwischen »klingt richtig« und »ist richtig«. Für den, der es benutzt, ist diese Unterscheidung allerdings existenziell. Zahlen, Fakten, Quellen – immer gegenprüfen. Immer. Mehr dazu im Artikel KI Nachteile.

Was ChatGPT gut kann

Gerade weil ChatGPT ein Sprachmodell ist, eignet es sich hervorragend für Aufgaben, bei denen Sprache im Mittelpunkt steht: Texte umformulieren, Entwürfe schreiben, Inhalte zusammenfassen, Ideen strukturieren, Fragen erklären, verschiedene Perspektiven formulieren, Code schreiben, übersetzen, Tabellen erstellen, Gespräche simulieren.

Überall dort, wo es um Form, Stil, Struktur und Varianten geht, ist das System stark. ChatGPT ist ein exzellenter erster Entwurf. Ein brauchbarer Sparringspartner. Ein geduldiger Erklärer, der nie müde wird. Es ersetzt keine Expertise, aber es beschleunigt fast jeden Arbeitsprozess, der mit Text zu tun hat. Wie du anfängst, ist schnell erklärt.

Seit 2024 kann ChatGPT außerdem Bilder erzeugen, Dokumente analysieren, im Web suchen und mit Plugins auf externe Datenquellen zugreifen. Das ursprüngliche Sprachmodell ist zum Ökosystem gewachsen. Aber im Kern bleibt es, was es war: eine Maschine, die das nächste Wort vorhersagt.

Was ChatGPT nicht kann

ChatGPT kann keine eigenen Erfahrungen machen, keine Absichten verfolgen und keine verlässlichen Entscheidungen treffen. Es kann keine Fakten garantieren und keine Verantwortung übernehmen. Für rechtliche, medizinische oder finanzielle Entscheidungen ist es ungeeignet – jedenfalls als alleinige Quelle.

Es kann auch nicht rechnen. Nicht wirklich. Mathematik ist für ein Sprachmodell eine Fremdsprache. Es kann Rechenaufgaben lösen, die es in seinen Trainingsdaten gesehen hat, aber bei neuen Problemen rät es – und liegt regelmäßig daneben. Die neueren Reasoning-Modelle sind besser, aber nicht fehlerfrei.

Und es hat keinen Zugang zu aktuellen Informationen, es sei denn, die Websuche ist aktiviert. Das Wissen des Modells endet mit dem Trainingszeitraum. Was danach passiert ist, existiert für ChatGPT nicht – oder nur als Gerücht in Form von Mustern, die zufällig passen.

Diese Grenzen sind keine Schwäche im eigentlichen Sinn. Sie sind direkte Konsequenzen der Funktionsweise. Wer sie kennt, wird nicht enttäuscht.

ChatGPT, Claude, Gemini – wo liegt der Unterschied?

ChatGPT ist nicht die einzige KI dieser Art. Claude (von Anthropic), Gemini (von Google) und weitere Modelle funktionieren nach demselben Grundprinzip: Textvorhersage auf Basis riesiger Trainingsdaten. Die Unterschiede liegen im Training, in der Feinabstimmung und in den Sicherheitsmechanismen.

Claude gilt als besonders gut bei längeren Texten und sorgfältiger bei heiklen Themen. Gemini profitiert von Googles Dateninfrastruktur und der Integration in die Google-Dienste. ChatGPT hat das größte Ökosystem und die meisten Nutzer. Welches Modell »besser« ist, hängt von der Aufgabe ab. Den Überblick über die wichtigsten Begriffe liefert unser KI-Glossar.

Was sie alle gemeinsam haben: Keines von ihnen versteht, was es sagt. Sie alle sagen das nächste Wort vorher. Manche nur besser als andere.

Was heißt das für dich?

Die Frage »Wie funktioniert ChatGPT?« ist keine technische Spielerei. Wer das Prinzip versteht, benutzt das Werkzeug besser. Und fällt seltener auf seine Schwächen herein.

Drei Dinge, die aus dem Verständnis folgen: Erstens, ChatGPT ist so gut wie deine Eingabe. Je präziser der Prompt, desto besser das Ergebnis. Zweitens, alles gegenchecken, was nach Fakten klingt. Das System erfindet überzeugend. Drittens, es als Werkzeug benutzen, nicht als Autorität. ChatGPT ist ein Stift, kein Autor.

Das nächste Mal, wenn ChatGPT eine brillante Antwort liefert, weißt du: Da hat niemand nachgedacht. Da hat eine Maschine das plausibelste nächste Wort gewählt. Millionen Mal hintereinander. Dass dabei etwas Nützliches herauskommt, ist das eigentliche Wunder.